J. Cheminformatics 2024 | Reinvent 4:现代AI驱动的分子生成设计

今天介绍的是发表在《Journal of Cheminformatics》的一项经典且极具影响力的研究,由阿斯利康MolecularAI团队推出的REINVENT 4。这一平台被视为生成式分子设计领域的重要基石,凭借多年实践经验积累形成了系统化、稳定且高度实用的架构。REINVENT 4整合了循环神经网络与Transformer模型,并将迁移学习、强化学习与课程学习统一在同一框架中,使从头设计、R基团替换、文库构建、连接体设计、骨架跃迁与分子优化等任务都能够以自动化且可控的方式完成。其精细化的评分体系、丰富的先验模型与插件式扩展能力,使化学空间探索更为丰富高效。作者以结构基础设计示例展示了其在实际药物发现中的成熟应用价值,也再次凸显了其在生成式AI平台中的标杆地位。强烈推荐正在从事分子生成研究的同学深入学习这一工具,对于理解算法原理、熟悉工业级工作流与拓展研究能力都具有重要意义。

获取详情及资源:

0 摘要

REINVENT 4是一个现代化的开源生成式AI框架,用于小分子设计。该软件基于循环神经网络与Transformer架构进行分子生成,并将这些生成器无缝嵌入到通用的机器学习优化算法、迁移学习、强化学习以及课程学习中。REINVENT 4能够支持并推动从头设计、R基团替换、文库设计、连接体设计、骨架跃迁以及分子优化等多种任务。

该研究概述了软件及其整体设计,并详细讨论了相关算法及其应用。REINVENT 4以命令行工具的形式提供,用户可通过TOML或JSON格式的配置文件进行控制。该发布旨在为AI驱动的分子生成提供常用算法的参考实现,同时也希望构建一个用于教育和未来创新的分子设计框架。

该软件可从https://github.com/MolecularAI/REINVENT4获取,并基于Apache 2.0协议开放。其科学价值在于提供了一个用于生成式分子设计的开源参考实现,同时在实际的内部药物研发项目中也发挥着支撑作用。将常用的机器学习算法集中于一套代码框架并提供完整文档,将提升AI研究的透明度,并进一步促进创新、合作与教育的发展。

1 引言

分子设计旨在针对化学、材料科学或纳米技术中的特定问题创建具有期望性质的全新分子,理想情况下应采用系统化的方法而非反复试错。在药物发现中,常通过理性药物设计来生成新的候选分子,而所谓的de novo方法则从零开始构建分子,即在几乎没有先验分子信息的情况下完成设计。在此背景下介绍基于生成式AI模型的de novo分子设计,并重点讨论REINVENT软件的实现。AI在药物研发中的应用一直存在争议,因此将常用的生成式分子设计算法以公开、可复现的形式提供给学界具有重要意义,也希望这些开源工具能够促进教育与创新。

生成式AI模型通过学习已知分子的概率分布及其局部关系来近似刻画未知的化学空间,并可通过统计采样生成新的结构。尽管这一领域仍较新,但已有一些实验验证逐步出现,同时出现了大量综述与方法学讨论。当前不仅小分子设计受到关注,其他分子类型的生成式方法也在发展中。用于分子生成的AI架构多种多样,包括VAE、GAN、RNN、Transformer、流模型、扩散模型以及基于反应的模型等,所使用的分子表征方式因维度不同而异,各类方法均各有优势,尚无通用最优方案。同时,一系列技术基准被提出用于评估分子生成与优化的表现。

分子设计可被视为一个逆向设计问题,与传统由结构推性质的正向设计不同,逆向设计先确定性质,再由算法生成可满足这些性质的分子。药物必须满足严格的性质要求,包括作用靶点亲和力、选择性、理化性质、ADME、PK/PD、毒性、安全性、化学稳定性、可合成性、可规模化和绿色化学等,这使得逆向设计极具挑战。逆向设计的核心在于从高维性质空间映射回广阔的化学空间。分子设计也是DMTA循环的一部分,生成式模型负责设计,而自动化平台可承担合成、测试与分析,以期构建一个闭环实验系统,提高研发效率,最终实现较高程度的自动化。

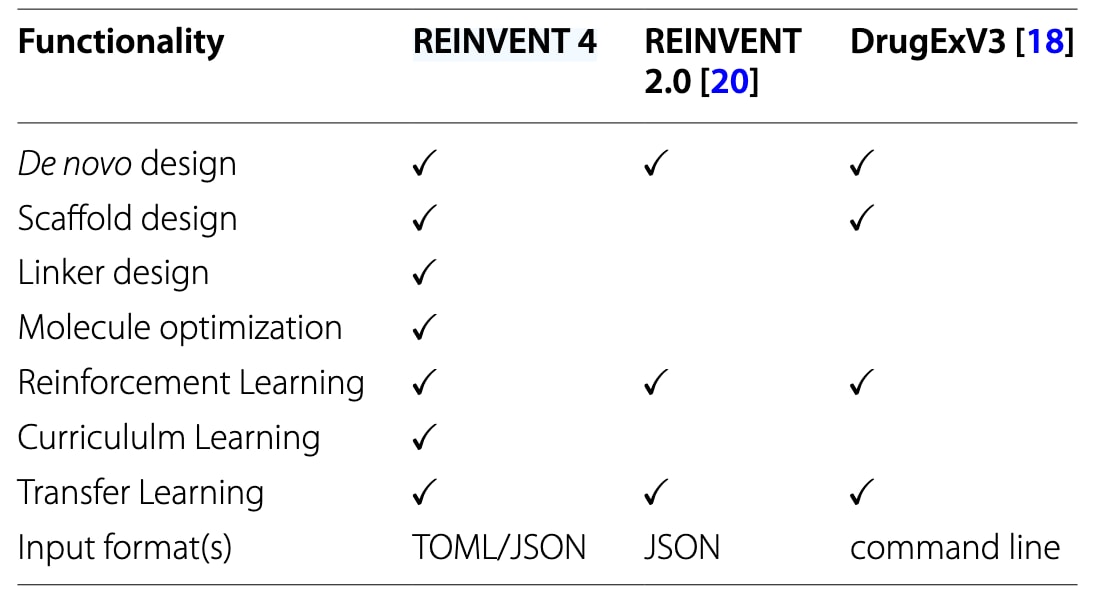

该研究描述了REINVENT作为生成式分子设计框架的发展。REINVENT已投入实际药物研发使用,并持续维护。其利用强化学习结合RNN与Transformer架构,以SMILES为分子表示解决逆向设计问题。新版REINVENT 4强调多项新特性,包括强化学习与课程学习的组合式分阶段训练、新的Transformer模型、在迁移学习、强化学习与课程学习框架中对所有生成器的全面整合、采用插件系统改写的评分子系统以及除了JSON外新增的TOML配置格式。REINVENT 4具有结构清晰且功能完整的软件实现,代码库几乎完全重写并集中托管于同一仓库。此前版本1与2.0已有详细发表,版本3虽开源但未附对应论文。REINVENT在采样效率上已优于多种方法,并在最近的对接基准中展示了生成逼真3D结构的能力。此外,也有研究表明在特定课程学习策略下,其能够生成超出训练集范围的化学结构。表1总结了REINVENT 4、REINVENT 2.0与DrugEx 3在功能上的差异,DrugEx亦是与REINVENT理念相近并投入实际使用的开源生成式AI平台。

表1 | REINVENT与DrugEx主要功能的比较

2 Theory

该节介绍REINVENT 4的理论基础,并强调其软件实现的关键细节,同时将先前文献中分散的功能加以系统化整理。

2.1 Generating molecules

REINVENT 4中的所有模型均为基于序列的神经网络,其参数化目标是以自回归方式生成token。模型被称为agent,序列对应SMILES字符串,其token为SMILES中的字符或字符组合,取自训练时构建并在推理时固定的词表

无条件agent生成长度为

条件agent在已知输入序列

据此定义负对数似然:

与早期版本一致,REINVENT 4提供多种prior agent,它们作为基础模型以teacher-forcing方式在大规模公开分子数据上无监督训练,使模型习得SMILES语法,并能生成合法分子。训练目标即最小化上述

REINVENT 4支持两种解码策略:多项式采样与beam search。多项式采样速度快且具有随机性,通过温度参数

REINVENT 4还包含Mol2Mol这一条件prior,用于系统探索化学空间。该prior在超过2000亿对来自PubChem且Tanimoto相似度≥0.50的分子上训练,并利用ranking loss进行正则化,使负对数似然可与结构相似性直接关联。

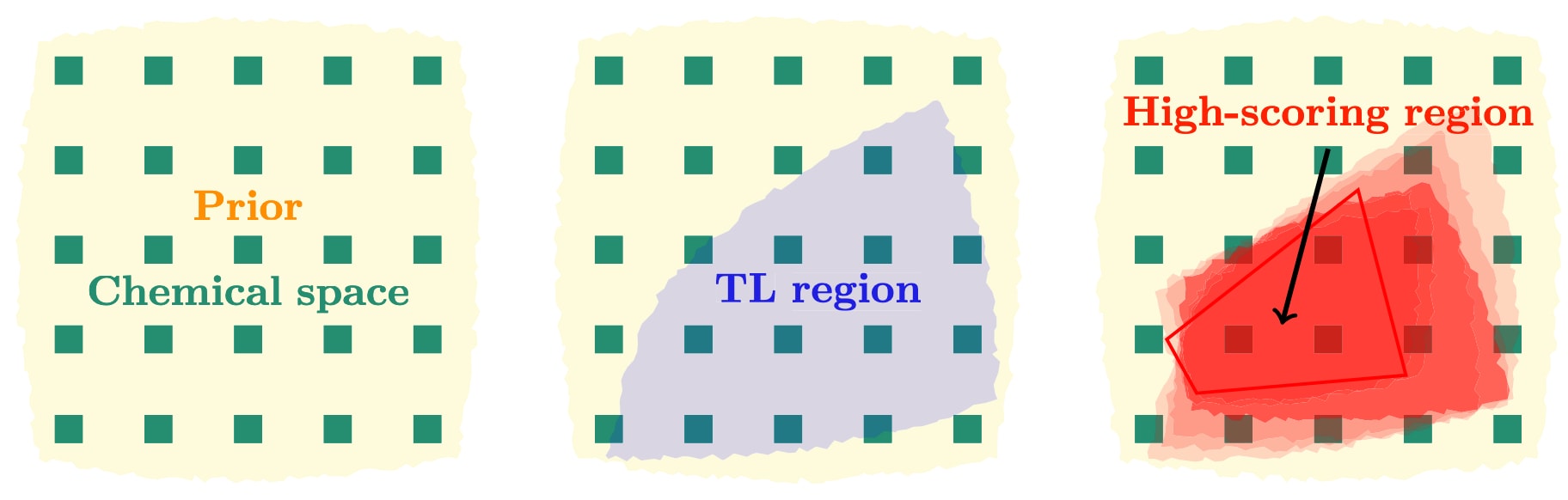

图1 | 该图示意了prior、迁移学习agent以及强化学习/分阶段学习agent的理想化行为。 在所有情况下,模型均描述了对某一token序列(对应特定分子,图中绿色方块)的采样概率,并以颜色深浅表示概率大小。prior经过训练后会提升对所有药物样分子的采样概率。由prior构建的迁移学习agent会在特定区域提高概率(图中蓝色,中间)。在分阶段学习中(红色,右侧),模型从迁移学习agent出发,通过迭代逐步提高对高评分序列的采样概率,使分布逐渐集中到高评分区域(红色多边形)。

2.2 Transfer learning

迁移学习旨在复用已有知识以促进相关任务的学习。在机器学习中,这通常表现为利用少量数据对大型模型进行再训练,从而在数据有限的情况下高效获得新的改进模型,因此可视作对既有模型的微调。迁移学习在药物发现中已有成功应用,研究表明,通过聚焦的生成模型可以获得与经验回放相似比例的活性分子。在REINVENT 4中,迁移学习被设计为以与先前pre-training相同的teacher-forcing策略对prior进行再训练,使用的是规模较小且任务相关的数据集,例如特定靶点的活性分子集。迁移学习最终生成一个新的agent,使其更倾向于产生与这些活性分子类似的结构,从而更快速地生成与任务相关的候选结构。

2.3 Reinforcement learning

强化学习描述一类优化方法,其中agent在环境中不断采取行动并从反馈中学习策略。在生成式分子设计中,目标是使prior生成的分子逐步满足预设性质。REINVENT采用基于策略梯度的方案迭代地调整agent生成的分子,关键不在于训练出一个全新的模型,而在于生成在评分函数下得分更高的分子。具体而言,为每个生成的分子序列

其中

并通过对批次平均损失的随机梯度下降更新agent。先验在此过程中保持静态,从而限制agent偏离prior的程度,类似于近端策略优化中的约束。

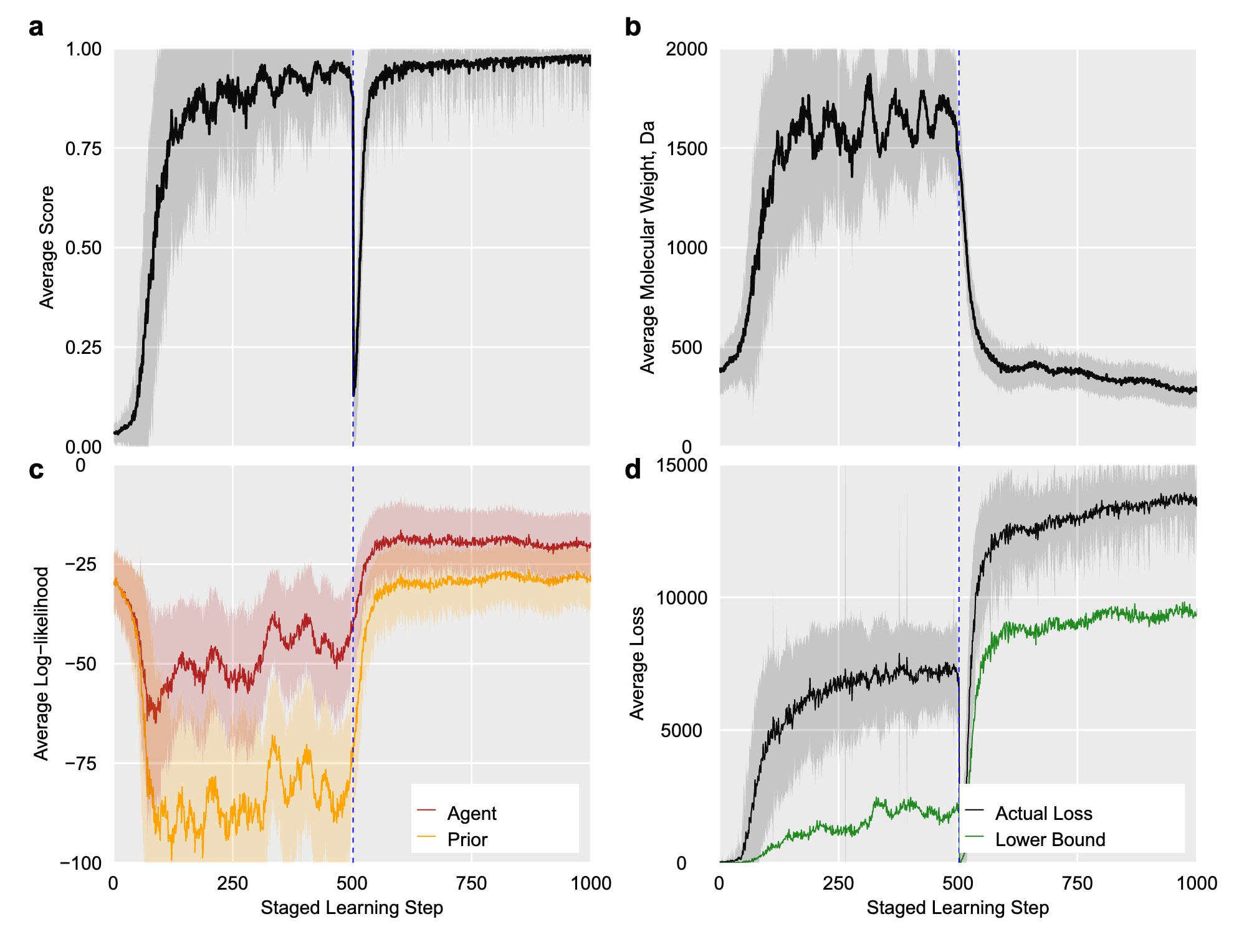

这一定义带来一些隐含性质:由于得分非负,增强似然总是相对于prior增加或保持不变,因此得分为零的分子不会推动学习,这意味着早期来自负例的学习有限。不过在动态调整奖励的情况下,agent表现会出现明显变化。一个示例是先驱模型在前500个epoch中被驱动生成超大分子,而后在第500个epoch之后评分函数突然改为偏好小分子,agent在短期内即可恢复生成小分子。这一快速回退与再适应体现了模型的可塑性,使其能够在主动学习或课程学习等情境中保持适应性。

由于增强似然的范围为

由于每个epoch使用新的分子批次,损失在学习过程中可能随得分上升而上升,但这是预期行为,体现了模型在不断适应新的高得分空间。整体而言,在先验更可能生成且评分也高的结构上,损失下界会更高,正如示例第二阶段生成药物样分子时的情况。

图2|展示了一个简单实验,用于说明默认REINVENT 4 agent的可适应学习行为。 首先进行500个epoch的强化学习,评分函数奖励分子量≥1500 Da;随后在第二阶段切换评分函数,奖励分子量≤1500 Da。图中分别给出了每个epoch结束时所有分子的平均得分a、平均分子量b、agent与prior的平均似然c以及损失函数d,同时在d中标示了损失下界(公式7)。虚线表示评分函数切换的时间点。该次实验使用默认设置:batch size为128,σ为128。

3 方法

3.1 强化学习

强化学习是REINVENT中用于分子优化的核心方法。在REINVENT 4中,强化学习被重新组织为分阶段学习,这允许在单个流程中依次执行多个RL阶段,并在不同阶段使用不同参数。每个阶段会输出一个CSV文件,其中包含负对数似然、总评分、各评分组件以及采样得到的SMILES字符串。该CSV文件以实时方式写入磁盘,即每个epoch生成的数据会立即记录(尽管操作系统可能进行缓冲以分块写入)。这意味着CSV文件中的数据未经过任何过滤,包括无效SMILES与低分子都会被完整记录,用户需自行在后处理步骤中进行筛选与分析。

3.1.1 强化学习策略

先前版本提出了四种RL策略,其中DAP表现出最高的学习效率,而其他策略的提升较小或几乎没有。在REINVENT 4中这四种策略仍全部提供,但建议实际应用中采用DAP,其余策略被视为deprecated,未来版本可能移除。

3.1.2 多样性过滤器

多样性过滤器旨在在RL过程中促进分子结构的多样性,主要基于骨架多样性并依赖一个可调大小的记忆结构。该记忆由多个“bucket”组成,每个bucket对应一个骨架。当某一骨架的bucket被填满后,该骨架在后续出现时会被整体赋予零分。骨架可按Murcko骨架定义,以“拓扑”方式计算(忽略原子类型与键类型的无标签图),或按骨架相似度存储与当前最相似的骨架。

所有骨架过滤器还包含一个全局SMILES记忆,其大小为1,意味着每当某个canonical SMILES再次出现时,无论在当前批次还是整个运行过程中,都会被打零分。在生成前不会对SMILES进行去重,以保持与先前版本一致,否则会改变损失计算行为,因为重复分子在评分为零时其负对数似然仍会被纳入计算。另外还有一种特殊过滤器仅惩罚完全相同分子的重复出现,不涉及骨架过滤。该过滤器特别适用于Mol2Mol生成器,可由用户设定惩罚强度(0到1之间)。

3.1.3 经验回放

Inception,也称为经验回放,对学习速率与目标分子的采样具有显著影响。在REINVENT中,它作为一种机制,用于存储最高得分的分子,并在计算损失时除了当前批次分子的得分外,还利用这些已记忆分子的得分参与损失计算。由此总损失由两部分组成:batch loss与inception loss。用户可以调节用于inception loss的记忆分子数量,以及从记忆中随机抽取用于计算的分子数量。当前这一记忆机制仅适用于原始的Reinvent分子生成器。

Inception记忆可由用户提供的SMILES进行初始化,以引导强化学习朝特定化学空间区域推进。但若这些分子在当前评分函数下得分较低,它们会在运行早期就被记忆剔除。随着RL迭代推进,系统会逐步生成更高得分分子,因此这种替换是常见现象。需要注意的是,当inception记忆较大且采样比例较高时,损失及后续生成倾向会逐渐被记忆中最高得分结构主导,使得在长时间RL中记忆更新效应变弱甚至几乎不再发生。

3.1.4 其他函数

用户可调整batch size,即每一步采样的SMILES数量。虽然改变batch size能够影响学习速率,但需注意其同时影响Adam优化算法的收敛行为。SMILES随机化可按需开启,尤其适用于LibInvent与LinkInvent,因为这些prior通过随机化SMILES训练以提升化学空间的泛化能力并避免过拟合。SMILES随机化本质上是一种数据增强方法,可在数据量较小的情况下构建更加鲁棒的模型。

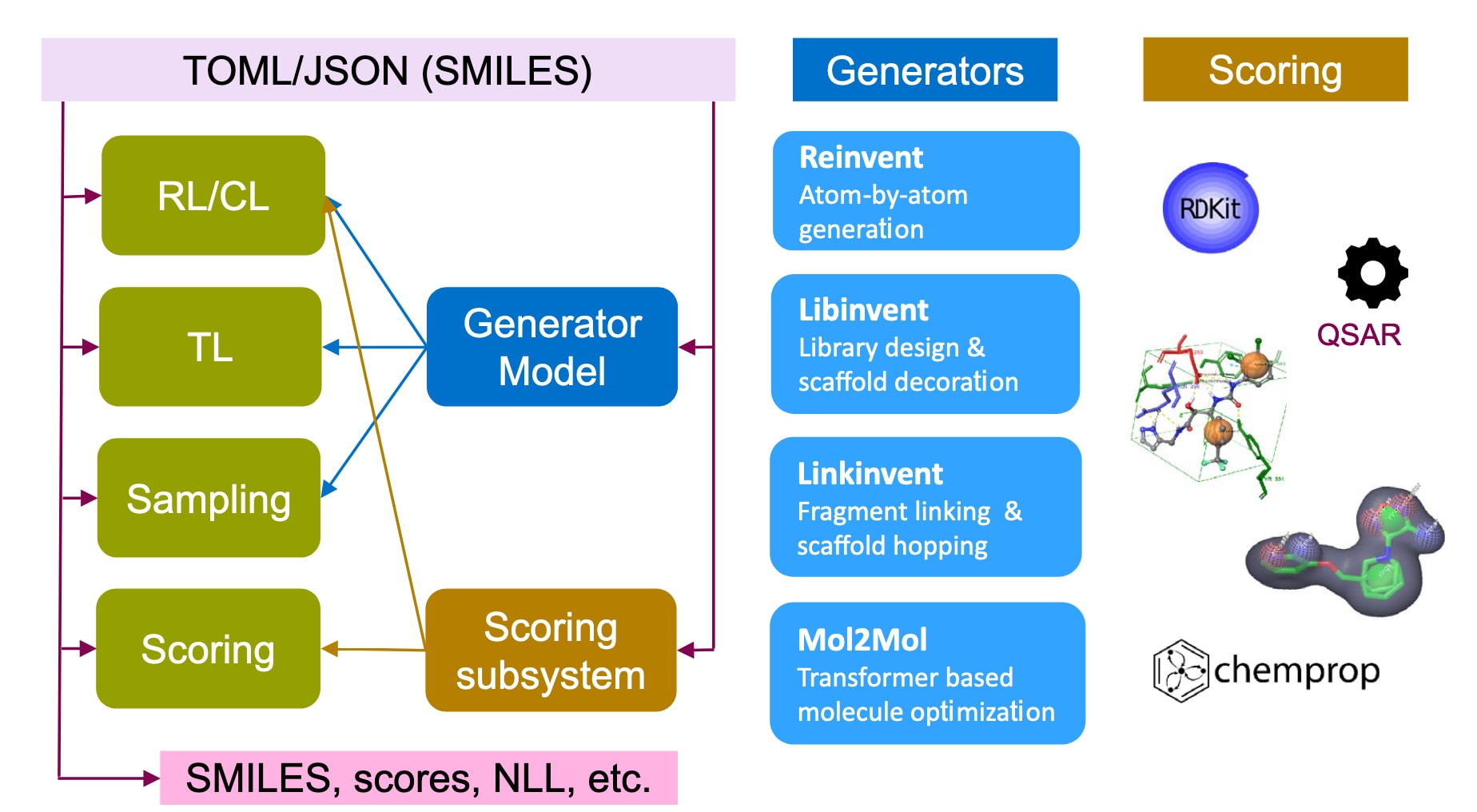

图3|展示了REINVENT 4在所有运行模式下的信息流结构(左侧绿色方框),同时给出了可用的生成器以及评分子系统。 软件的所有操作均由一份TOML或JSON格式的输入配置文件控制,配置文件还可包含用于LibInvent、LinkInvent与Mol2Mol生成器的“seed” SMILES。对于分阶段学习、迁移学习与评分模式,需要提供输入SMILES。图中NLL表示负对数似然,其定义见公式3与公式4。

3.2 运行模式

REINVENT 4支持多种“运行模式”,以下进行简要说明。所有模式均可在GPU或CPU上运行,迁移学习与强化学习模式会生成对应的TensorBoard输出。图3给出了REINVENT 4中信息流的基本结构。输入的配置文件示例(TOML格式)可参见附加文件。所有SMILES在进入学习算法前会经由RDKit进行规范化与标准化处理。需要注意的是,仅Mol2Mol prior支持立体化学信息。

3.2.1 打分

该模式将输入的SMILES传入评分子系统,并将结果输出为CSV文件。该文件包含SMILES、总分、各评分组件的“原始”分数与“变换后”分数。输入的重复SMILES不会被移除,因此输出可能出现重复行。

3.2.2 采样

该模式基于TL或RL生成的模型生成新分子。对Reinvent无需提供输入SMILES;LibInvent需提供骨架;LinkInvent需提供两个warhead;Mol2Mol需提供一个输入分子。输出为CSV,包括生成的SMILES、输入或片段SMILES(如适用),以及生成SMILES对应的负对数似然(为正数)。输出SMILES将被规范化,并可选择去重。Mol2Mol支持多项式采样(含温度参数)与beam search两种方式。

3.2.3 迁移学习

该模式用于将通用模型优化为更接近用户指定分子集的生成器。用户需提供prior与一份SMILES文件,例如某化学系列。TL根据这些分子计算其负对数似然,并根据平均负对数似然形成损失,从而推动模型逐步逼近给定分子集。由于TL容易过拟合(模型可能开始直接生成与输入完全相同的分子),用户可提供验证集以监控验证损失,训练集与验证集的划分需由用户自行处理。TL最终输出新的模型文件,可用于后续RL或sampling。用户可设定epoch数量、模型写出频率与batch size。Mol2Mol还允许设置相似性类型及其上下阈值。

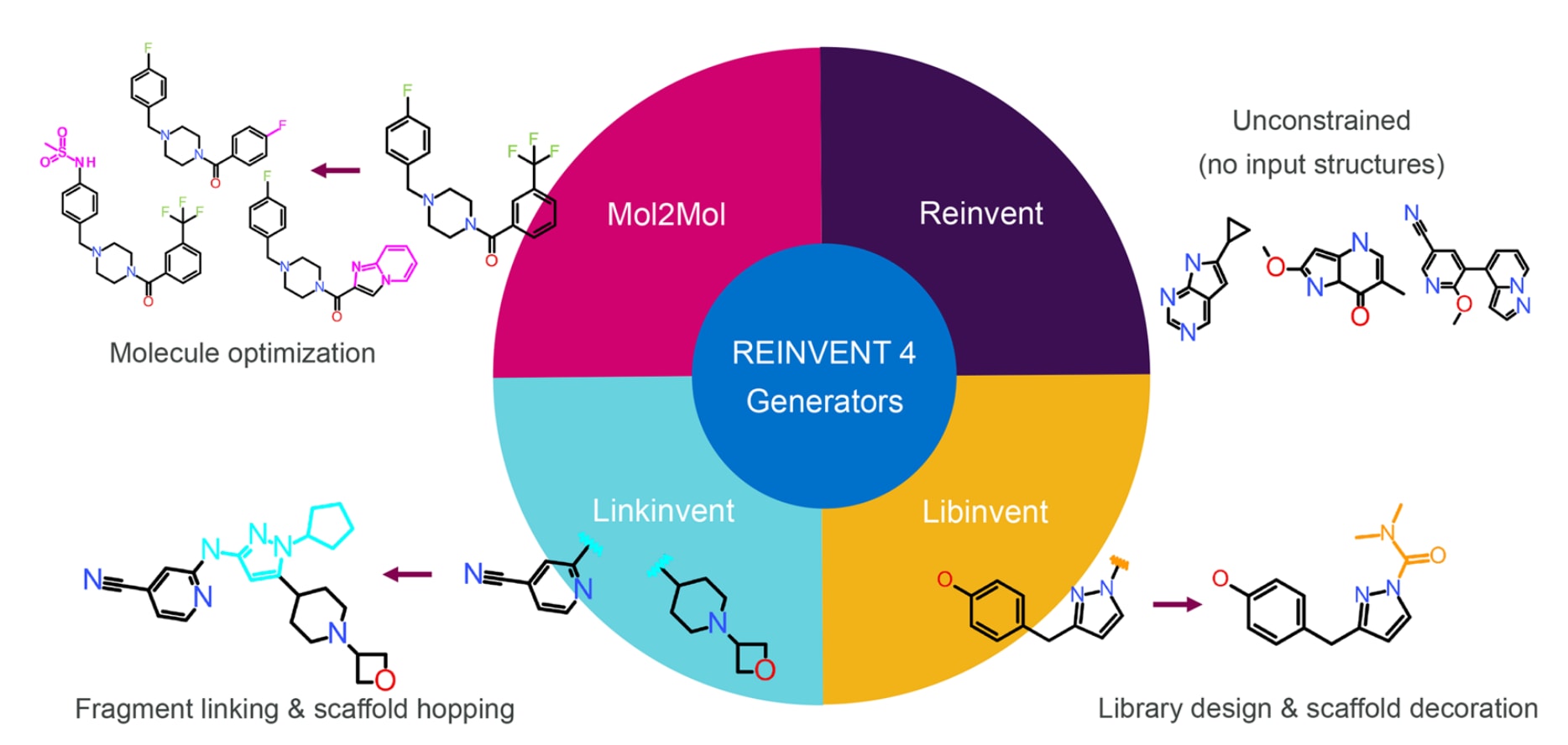

图4|展示了REINVENT 4中四类分子生成器的工作方式 :Reinvent从零开始进行de novo分子生成;LibInvent在给定骨架上进行R基团装饰;LinkInvent在两个片段之间生成合适的连接体;Mol2Mol在用户设定的相似性范围内对分子进行优化。

3.2.4 阶段学习

该部分实质上对应课程学习(CL),在REINVENT 4中以多阶段RL的形式实现。其主要目的在于通过分阶段调整评分函数,使prior在给定目标性质的约束下逐步得到优化。例如,在启用对接计算前,可以先通过自定义警示规则或其它快速评分函数筛掉不合适结构,再逐步加入更昂贵的计算。自定义警示通常由一系列不良化学基序的SMARTS模式组成。多个阶段可一次性定义(自动CL),也可逐阶段手动衔接(手动CL)。一个阶段在达到最大得分阈值或最大步数时终止;若是后者,则整个多阶段流程终止。

分阶段学习需要prior与agent两个模型。prior作为参考,而agent为真正被训练的模型。运行开始时两者通常相同。运行因条件满足或用户终止而结束时,会写出一个checkpoint文件,可作为后续阶段的agent再利用。与采样模式相似,用户需提供分子或片段SMILES(除Reinvent外无需输入)。Mol2Mol支持beam search与多项式采样。用户可设置batch size、是否随机化输入SMILES、以及是否强制生成唯一序列(为兼容旧版保留)。RL策略可通过σ调控评分贡献与学习率,多样性过滤器与Inception均为可选项。所有骨架过滤器需提供bucket大小,每条SMILES会存入一个独立记忆,并根据最小得分阈值决定是否加入记忆。相似骨架过滤器需要设置最小Dice相似度;相同SMILES惩罚过滤器允许设置惩罚倍数;Inception可选地以SMILES初始化,并允许设定记忆大小与采样数。

每个阶段可定义独立的评分配置,也可从外部文件(TOML或JSON)读取。阶段在达到最大得分阈值时进入下一阶段(若存在),达到最大步数则终止整个流程。由于未达到得分阈值可能意味该阶段存在问题,因此需用户检查。用户还可设定最少步数以避免过早终止。结果以CSV输出,每一阶段对应一个文件,可设定文件名前缀。CSV包含prior、agent与增强似然的负对数似然,生成的SMILES,总分与各组件分数(原始与变换后),以及当前步数。

3.3 分子生成器

REINVENT 4支持多种生成器(见图4),每一种生成器均基于特定约束生成新分子,其项目名称与先前文献一致:

-

De novo design

利用RNN按序逐原子构建分子,为最经典的de novo生成算法。(Reinvent)

-

R基团替换与文库设计

提供骨架作为模板与约束,生成器将为其装饰合适R基团,支持最多四个连接点,可用于AI指导的分子文库设计。(LibInvent)

-

片段连接与骨架跃迁

提供两个warhead,生成器将构建连接两者的linker。linker可为任意在prior训练空间内的骨架。(LinkInvent)

-

分子优化

提供一个分子作为约束,生成器将在设定相似性范围内找到第二个分子。该范围允许骨架在相似性限度内变化。(Mol2Mol)

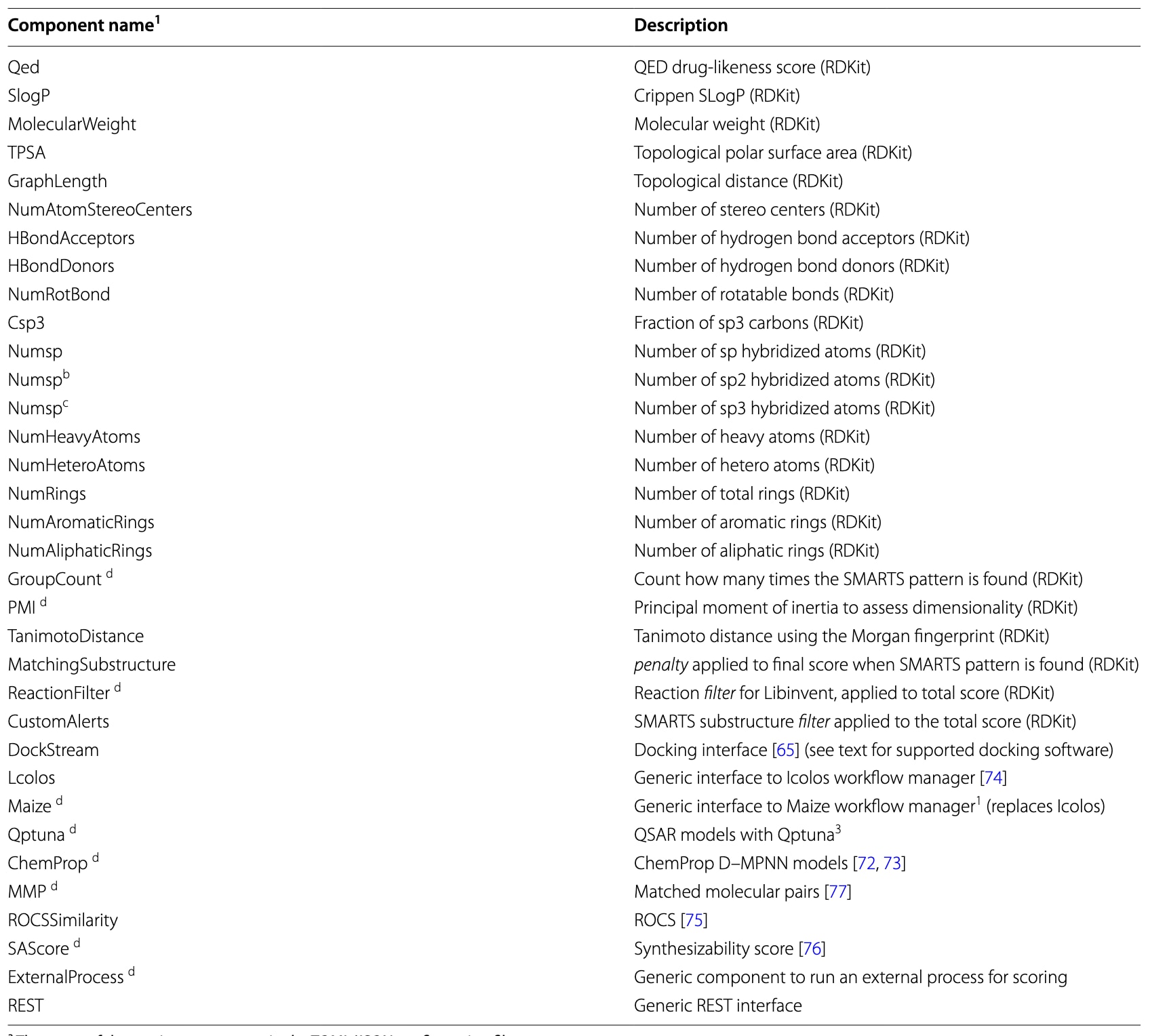

表2 | REINVENT 4评分函数的总结。

3.4 打分子系统

强化学习是一类优化算法,其核心思想是奖励期望的行为。在该研究情境中,即通过用户定义的评分函数集合对分子进行优化,这些评分会被汇总后输入到公式6中。REINVENT 4支持种类丰富的评分函数,其概览见表2。大多数组件具有多个“端点”,例如可为GroupCount提供多个SMARTS模式,或在PMI中同时计算两个转动惯量比。此外,多任务模型也自然适用于该机制,用户可选择需要的端点子集。为了避免重复计算,每条SMILES的各组件得分都会缓存。由于prior生成的SMILES不一定为规范化形式,所有SMILES都会以RDKit的canonical形式传入评分系统;重复SMILES会被标记并由缓存机制处理。Mol2Mol模式下的手性信息会被保留。每个评分组件可根据其模型需要对SMILES进行再规范化,这在模型训练或运行时依赖不同规范化方案时尤为重要。

需要注意的是,custom alerts与reaction filter作为全局过滤器存在,并不属于评分组件。其效果等同于将总分乘以过滤结果,即通过则为1,不通过则为0。出于效率考虑,未通过过滤的SMILES不会继续计算任何评分,其所有组件分数皆为0。此外,目前有一个全局惩罚组件:匹配子结构,它会对最终总分施加惩罚倍数。

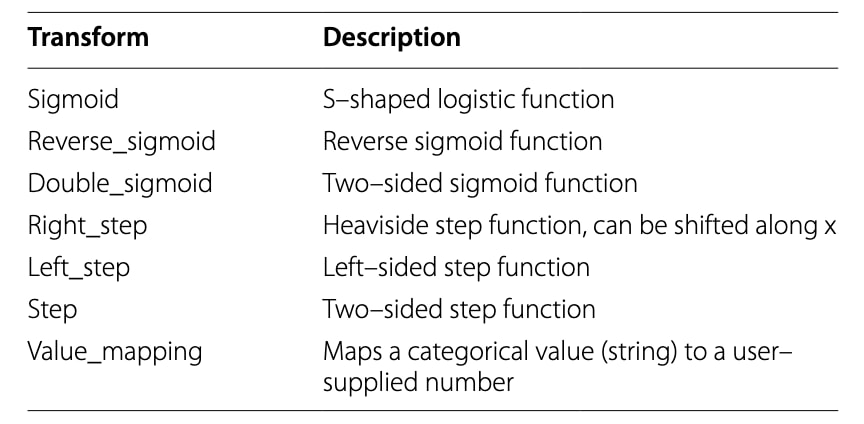

许多评分函数用于评估RDKit提供的理化性质,如Lipinski规则、QED等;LinkInvent还提供这些性质的片段版本,以便对生成的linker进行独立评分。对接则通过DockStream接口处理,支持AutoDock Vina、rDock、Hybrid、Glide与GOLD。QSAR模型由Qptuna处理,ChemProp提供基于D-MPNN的替代方案。更复杂的流程可通过ICOLOS构建,未来将被Maize取代。也提供REST接口用于调用外部评分程序,使用户可实现任意自定义评分逻辑;形状相似性可通过ROCS计算;可合成性可使用SA score评估;匹配分子对则可通过mmpdb使用。每个评分结果可通过转换函数压缩至0到1,转换方法列于表3;每个端点需设定权重以决定其相对重要性。最终,各组件评分将聚合为一个单一总分,目前支持加权算术平均与加权几何平均。评分子系统采用插件机制构建,只需将新代码按模板放入插件目录即可,无需修改REINVENT 4核心代码。

3.5 先验

REINVENT 4提供一系列现成的prior模型,这些模型预先在ChEMBL上训练(Mol2Mol除外,它在PubChem上训练),并针对不同的生成器类型进行优化。所有可用priors的总结见表4;附加文件列出了其所有token。所有priors支持相同元素,主要差异在于环尺寸及Mol2Mol对手性中心与双键异构体的支持与生成能力。

表3|REINVENT 4中各类变换函数的总结。

表4|REINVENT 4中可用prior模型的总结。 Mol2Mol包含六种不同的prior,其成对模型基于不同类型的相似性进行训练。

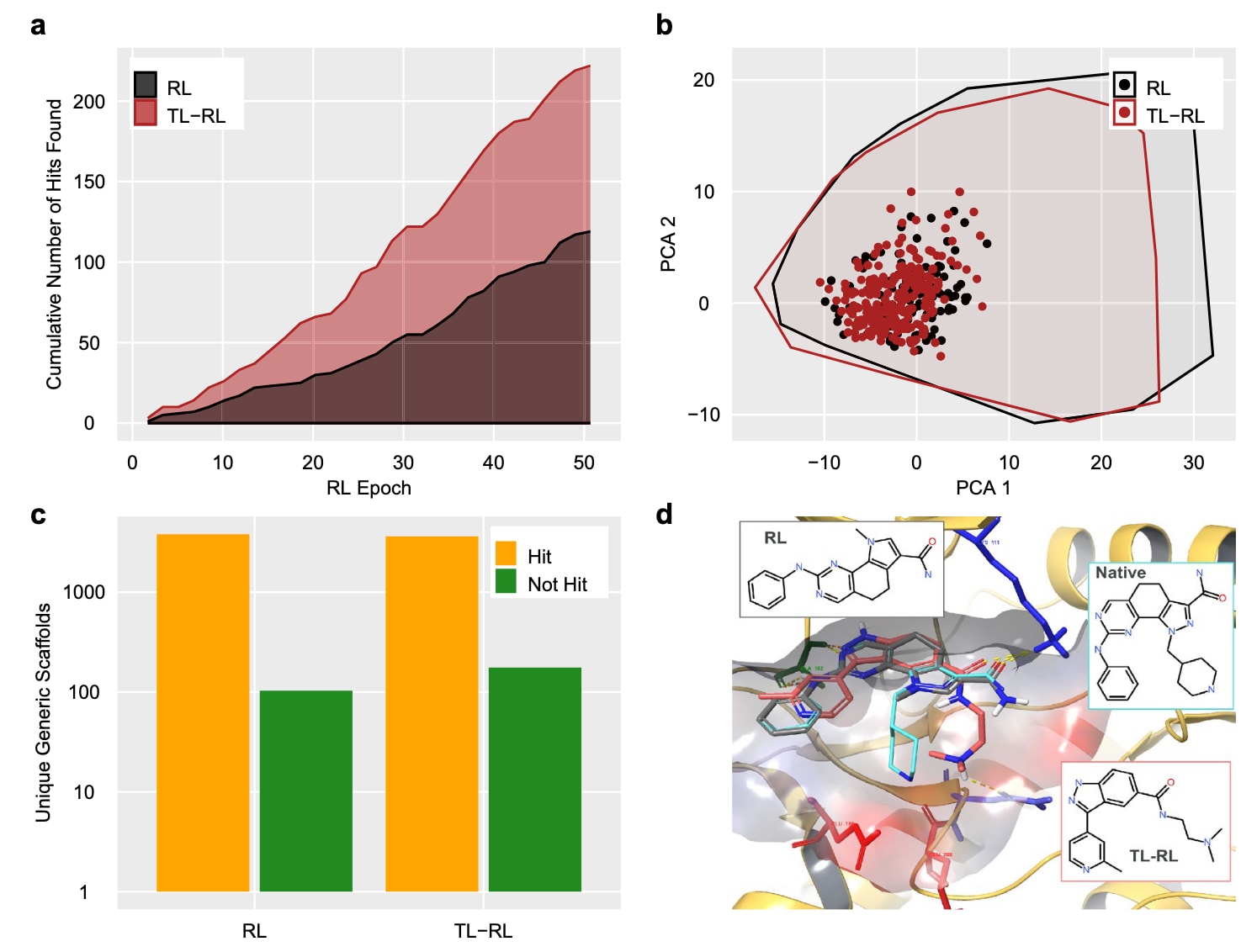

图5|展示了在REINVENT 4中利用PDK1晶体结构(PDB ID 2XCH)进行简单双靶点结构设计的示例。 (a)显示了在50个epoch中累计识别到的命中数量,其中黑色曲线对应从prior直接进行强化学习(RL),红色曲线对应经迁移学习后的强化学习(TL-RL)。结果表明TL-RL的命中累积速度更快。(b)通过基于RDKit二维描述符的主成分分析(PCA)比较了命中分子的多样性,图中命中以彩色圆点表示,同时给出了所有生成分子的凸包多边形,以体现结构空间覆盖范围。(c)统计了命中与未命中的独特通用骨架数量,用以进一步度量多样性。两种方法均展现出高骨架多样性。(d)展示了两种方法所得最高评分分子在PDK1结合口袋中的预测结合构象,并以stick形式表示,同时以青色展示天然配体作为对照。两者的对接得分均为−10.1 kcal/mol。蛋白以cartoon表示,关键氨基酸残基(ALA162绿色、LYS111蓝色、GLU166红色、GLU209红色、ASN210蓝色)以stick形式显示,并叠加透明的结合位点表面。图中右侧的二维插图展示了对应配体结构。命中定义为对接得分≤−8 kcal/mol且QED≥0.7的分子。

4 案例研究

提供一个简单示例以展示REINVENT 4部分关键功能,模拟一次虚拟筛选寻找新型PDK1抑制剂的任务。此前已有更详尽的研究报道,该示例则采用简化的结构基础设计思路。定义的目标由对接得分与QED组成,使用DockStream在PDB结构2XCH上无约束对接。任意对接得分≤−8 kcal/mol且QED≥0.7的分子视为命中。自标准Reinvent prior出发运行50个epoch的分阶段学习,batch size为128。尽管运行较短,但在6400个生成分子中得到119个命中,命中率为1.9%,且后期epoch的效率进一步提高。命中分子跨越103种Murcko骨架,展现高度多样性。得分最高者为一种与天然抑制剂核心高度相似的结构,其对接构象也与天然配体几乎一致。

为展示迁移学习的优势,从PubChem的AID1798002中获取315个活性分子,进行10个epoch的TL后再次执行同一设计流程。尽管这些化合物与天然配体结构上差异较大,但TL agent在50个epoch中获得222个命中,命中率达3.5%,几乎是基线RL的两倍,且骨架多样性更高。其最优构象包含能与LYS 111形成相同相互作用的核心结构,并提出合理的结合假说,尽管与ALA 162的hinge相互作用不完整,可通过在对接网格中加入约束改善。

5 讨论

该研究介绍了REINVENT 4的技术细节与基本用法。作为对以往版本的延续与重要升级,新版引入分阶段学习、Transformer模型、更一致的优化算法框架以及为未来挑战重构的评分子系统。希望这一开源软件及其完整文档能为化学AI领域提供参考实现,提高AI驱动分子设计的透明度,并推动教育与进一步创新。软件可从https://github.com/MolecularAI/REINVENT4获取。