ACS Cent. Sci. 2025 | SynLlama: 用大型语言模型生成可合成分子及其类似物

今天介绍的这项工作来自 ACS Central Science。该研究提出SynLlama是一套面向可合成分子设计与路线规划的工作流,核心是将通用的Llama3通过数据高效的有监督微调转化为“会做逆合成”的专家模型:模型以SMILES表示分子、以SMARTS表示反应模板,在推理时先把输入目标分子按预测的反应模板序列逐步拆解,输出由反应序列(RXN)与构建块(BB)组成的逆合成结果,随后由重构算法按顺序将这些模板应用到构建块上,得到可执行的多步合成路线,并据此实现对目标分子的完整重构或生成结构相近的可合成类似物。它依托约23万个Enamine构建块与两套常见有机反应模板定义了一个规模巨大的可合成化学空间,在较少训练路线数量的条件下仍能在合成规划、为从头生成分子寻找可合成替代物、以及围绕命中分子进行局部结构扩展等药物发现任务中表现出竞争力。与只在固定构建块集合内搜索的部分方法不同,SynLlama由于底座是通用语言模型,对构建块更倾向于学习分布而非死记硬背,因此能在一定程度上外推到训练集中未出现但可购买的构建块,为难以重构的药物样分子提供额外合成路径,从而在尽量保持对接等药物相关性质的同时,显著提升合成可及性与实验可落地性。

获取详情及资源:

0 摘要

用于探索化学空间的生成式机器学习模型展现出巨大潜力,但这类模型生成的许多分子在实际中往往难以合成,从而降低了它们继续研究或开发的可行性。该工作提出一种新的思路:通过对Meta的Llama3大型语言模型进行微调,构建SynLlama,使其不仅生成分子,还能够直接生成完整的合成路线。生成的路线由常见且易获得的构建块以及经过验证的有机反应模板组成,从源头上强调可合成性与可操作性。SynLlama能够在显著更少的数据条件下探索更大的可合成化学空间,并且在正向合成预测与自底向上的合成规划任务中,相较其他先进方法表现出较强竞争力。结果还表明,即使未显式使用外部构建块数据进行训练,SynLlama仍能对未见过但可购买的构建块实现有效泛化,说明其重构与规划能力可以覆盖超出训练数据范围的更广可合成化学空间。进一步地,该方法在药物研发场景中得到展示,可用于围绕目标蛋白的候选抑制剂进行类似物的合成规划与命中扩展线索生成,从而为药物化学家的发现流程提供一种实用工具。

1 引言

计合成路线之所以成为可能,依赖于合成化学几十年的积累,以及对关键反应步骤机理的研究和对反应类型的系统分类。借助反应数据库中长期沉淀的大量数据,人们开发了专家系统,将这些知识用于构建通向指定目标产物的多步合成路线。这类方法已经成为实验化学家的重要工具,例如Chematica软件及其后续商业化产品Synthia就体现了这一点。

随着人工智能与深度学习的进展,生成模型开始在化学计量层面为分子枚举提供助力。通过在包含多种小分子表示形式的数据库上训练,基于字符串的一维生成模型以及结构感知的三维从头设计方法,使得对更大范围、未探索化学空间的快速搜索成为可能。然而,即便这些模型具备出色的生成能力,仍然面临一个关键挑战:它们提出的从头分子缺乏可合成性的实际保障,这会显著限制其在实践中的价值。要使面向药物与材料发现的生成式方法真正释放潜力,合成可行性必须得到保证,从而弥合计算机端分子设计与计算生成分子现实可用性之间的鸿沟。正因为意识到这种不匹配,相关研究开始着力缓解从头生成分子可合成性差的问题。

一条研究路线侧重于将经验型或深度学习的评分函数融入学习算法的目标函数,例如合成可及性评分SA以及DeepSA评分等。但仅仅优化可合成性评分仍可能生成难以合成的分子,原因在于这些评分函数通常依赖识别分子中的常见片段或反应中心。此外,对于需要多步合成路线的复杂但可合成分子,评分函数往往给出较差分数,从而使生成模型错过本可行的候选分子。还有一些方法尝试通过常见分子片段来拼装分子以提升可合成性,但由于未显式考虑反应路径,仍然无法对合成可行性给出可靠保证。另一些工作则转向基于规则的合成与优化,在构建块层面或整条合成路线层面生成同时满足目标化学性质的新分子。也有模型以输入分子为条件,利用商业可得的构建块和经过验证的反应模板,在预定义的化学搜索空间内以前向合成的方式实现目标分子的完整构建,或生成结构相近的类似物。比如SynNet通过马尔可夫决策过程构建合成树,并用多层感知机选择下一步动作空间。更近期的模型,如ChemProjector与Synformer,使用Transformer来解码下一步动作空间,在目标分子与类似物重构任务上取得了良好的经验表现。

一种更具吸引力的替代方案是采用大型语言模型,原因在于其基础性与对下游任务的适应能力。大型语言模型天然具备丰富的化学知识,近期研究也在尝试用自然语言引导的方式提取并应用这些知识,用于预测与优化任务。进一步地,经过微调后,大型语言模型的表现可以达到或超过仅在化学表示上训练的化学语言模型,同时所需数据更少。由此带来的效率提升与出人意料的性能增益,促使研究者探索大型语言模型在更复杂任务中的潜力,例如合成规划,从而为新的化学发现打开可能性。

该工作提出SynLlama,这是一个基于大型语言模型的工具,建立在开源的Llama-3.1-8B与Llama-3.2-1B基础模型之上,用于推断目标分子或结构相关类似物的合成路线。SynLlama中的大型语言模型部分作为受约束的逆合成模块,通过经过充分验证的反应序列将输入分子拆解为构建块。其重构模块则依据大型语言模型的预测,在商业可得的构建块中进行检索,并在多样且可合成的化学空间内逐步构建分子。作为应用示例,SynLlama在药物发现的关键任务中展示了具有竞争力的表现,包括面向具有药学价值的目标分子及其类似物的合成规划,以及围绕已有药物命中与先导分子进行扩展生成。与此同时,由于其生成式特性,SynLlama的大型语言模型组件还具备一项额外能力:能够探索超出训练阶段引入的预定义合成空间之外的商业可得构建块,而这是以往模型所不具备的。通过将分子设计与合成可行性相结合,SynLlama向着打通计算化学与合成化学迈出一步,为化学家提供具有可操作性且可在实验中获得的分子候选。

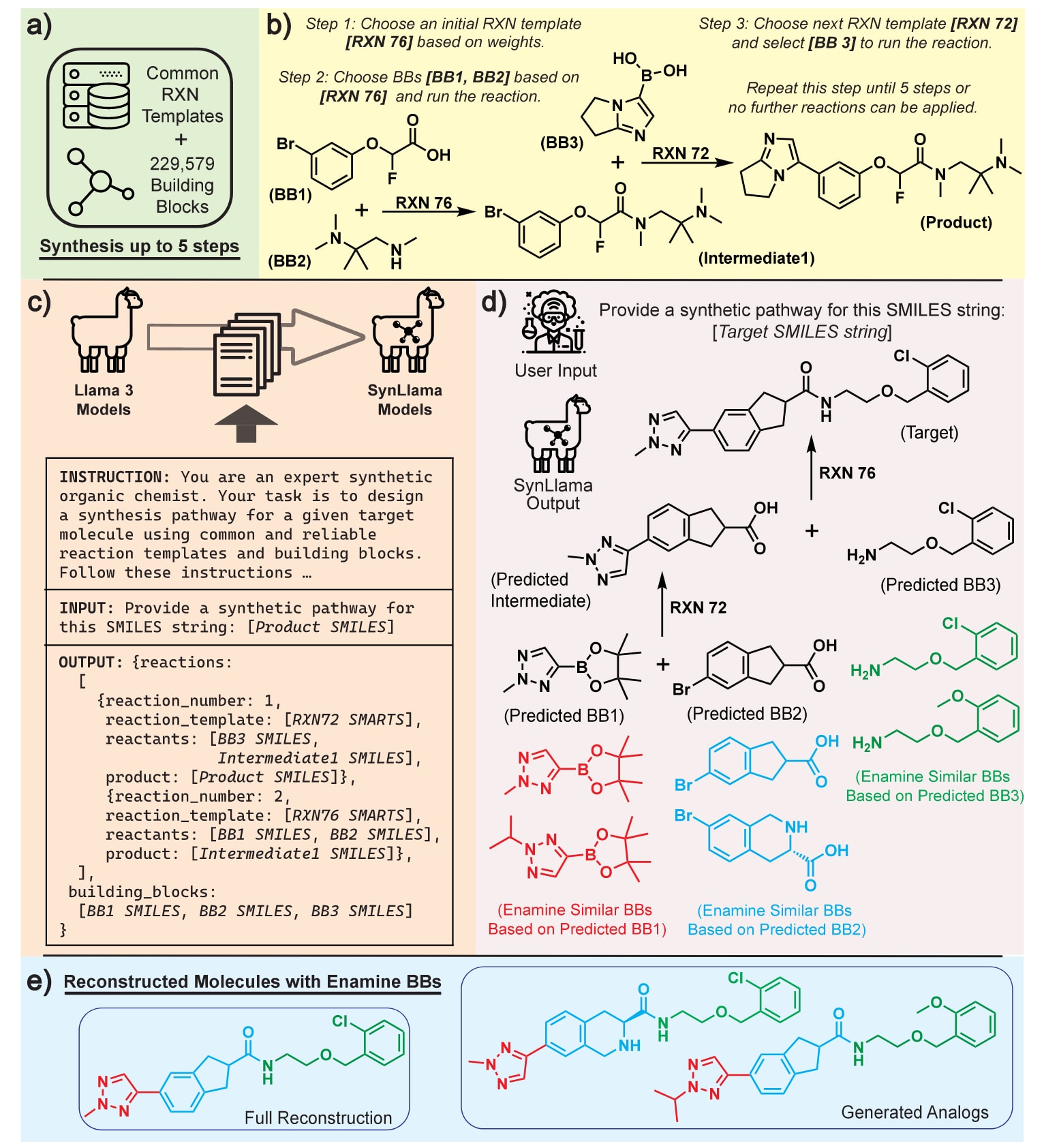

图1 | 展示了SynLlama工作流程概览,包括数据生成、有监督微调、推理与重构。 (a)由反应模板(RXN)与构建块(BB)组成的预定义可合成化学空间可覆盖数十亿级别的分子。(b)展示一个合成数据样例及其生成过程,从已定义的可合成化学空间中构造训练样本,其中RXN76表示酰胺偶联,RXN72表示Suzuki偶联。(c)有监督微调的示意图,用于将Llama3基础模型转换为SynLlama模型,并给出与(b)中示例合成对应的指令、输入与输出格式。(d)SynLlama对未见过的测试分子进行推理。黑色部分表示SynLlama直接输出的逆合成结果,由RXN序列与预测的BB组成;带颜色的BB表示在Enamine构建块库中与预测BB最相似的前两个候选,其中RXN76表示酰胺偶联,RXN72表示Suzuki偶联。(e)利用预测的反应序列以及从Enamine构建块库中检索到的相似构建块进行分子重构。在该示例中,所有预测构建块均能在Enamine库中找到,因此既可完整重构输入分子,也可生成结构非常接近的类似物。

2 方法

SynLlama的整体流程如图1所示,目标是在扩展的化学空间内生成具有可合成性的化合物。当输入分子经过这一流程时,要么能够通过有效的合成路径被完整重构,要么会得到一个结构相似且可合成的类似物,并同时给出其合成路线。为了将Llama3这类通用大型语言模型转化为能够处理合成路线的专家模型,该方法依赖三个关键组成:其一是覆盖大规模可合成化学空间、可靠且多样的反应数据;其二是高效的有监督微调(SFT)策略,使通用模型能够学习这些反应数据;其三是一个重构算法,将微调后模型的输出转化为有效的合成路线,并确保所提出的分子落在商业可获得的化学搜索空间之内。这些组成对于发挥大型语言模型在多类化学任务中的能力并将其专门化为合成建模任务至关重要

2.1 用于训练集与测试集的反应数据

如图1(a)所示,训练所定义的化学空间由满足以下条件的分子构成:最多五步即可由Enamine构建块(BB)与两组经过验证的常见有机反应模板(RXN)合成。为划分训练与测试的构建块数据,该方法采用时间切分策略:将Enamine在2024年8月发布版本中的全部构建块作为训练构建块,并将其在2025年2月发布版本中新增加且未出现在训练集合中的构建块作为测试构建块。由此得到约230000个训练构建块与约13000个测试构建块。随后在3.1节将进一步讨论对未见分子的目标重构,这些分子来自Enamine Diversity Set与ChEMBL数据集。

该方法定义了两组作用于Enamine构建块的反应模板集合。RXN1由Gao等人整理的一组91个反应模板构成,其来源可追溯至Hartenfeller等人与Button等人的工作。RXN2由Gao等人选择的115个反应构成,其中包含用于构建Enamine REAL空间的反应,并补充了RXN1中的部分反应。两套反应模板对训练与测试两类构建块均可用,从而共同定义训练与测试的化学空间。由此,该空间内约有

为在该空间内枚举分子,该方法采用迭代式策略,即先选择反应模板,再搜索与之兼容的构建块。具体而言,如图1(b)所示,初始反应模板的选择由一个概率模型引导,该概率模型基于可兼容构建块的数量。在这些兼容的构建块反应物中,初始构建块以随机方式选取,并通过所选反应模板生成一个中间体。随后以该中间体为基础继续匹配后续反应模板,并引入更多构建块来扩展合成路径,直至无法继续发生反应,或反应步数达到五步上限。经过此类表示上的训练后,得到的语言模型能够学习将输入分子映射为构建块与反应模板序列,从而为测试集合中的分子构建线性合成路线。

为检验模型在更困难合成情形下的泛化能力,该方法还构建了分支合成的测试集,其中分子至少包含一个或多个反应步骤,其反应物涉及中间体。在利用RXN1与RXN2模板构建分支合成测试集时,该方法同时维护两棵合成树,并检查两棵合成树产生的中间体分子是否能够在对应RXN集合中至少通过一个反应模板继续发生反应。之后筛选出至少包含一步以中间体作为反应物的分子,从而形成两套分支合成测试集。

2.2 SynLlama的有监督微调与推理

为得到SynLlama模型,需要建立面向Llama3模型的有监督微调(SFT)数据生成协议,其示意见图1(c)。在将反应数据生成文本格式时,该方法使用SMILES字符串表示合成路径中的构建块与中间体,并以SMARTS格式显式定义反应模板。此类结构化化学记号旨在增强SynLlama依据反应模板系统识别并解构化学键的能力,从而将输入分子有效拆解为构建块尺度的片段。由于目标是让SynLlama学习分子与其合成路线之间的关联,提示-响应对采用逆合成(retrosynthesis)组织方式,如图1(c)所示,更详细结构见补充图S1。通过这种设计的提示与响应,模型能够学习在给定输入分子时,推断构建块序列与反应模板序列,并给出相应的中间步骤来构建合成路径。尽管理论上模型可以在不显式给出中间体的情况下预测构建块与反应模板,该方法仍在每个反应步骤中包含中间体信息,以期激活大型语言模型内在的化学知识并增强其对合成模式的理解。关于正向合成与逆合成的设计取舍,以及是否对药物样产物分子进行过滤的分析,在Supporting Information中给出。

该方法在不同数据规模上对Llama-3.1-8B(80亿参数)与Llama-3.2-1B(10亿参数)进行SFT。具体而言,Llama-3.1-8B分别使用包含100k与500k条合成路线的数据集进行微调,对应需要40与240个A40-GPU小时。Llama-3.2-1B则使用包含500k与200万条合成条目的数据集进行训练,分别需要约60与240个A40-GPU小时。在结果部分的前半部分,训练后的模型以SynLlama(参数规模)(训练反应数量)的方式命名,例如SynLlama-1B-2M表示在Llama-3.2-1B基础上,用200万条合成路线微调得到的模型。关于SFT的更多细节同样在Supporting Information中提供。

在训练完成后,该方法使用一致的提示设置对分子进行推理。对于任意给定分子,SynLlama会以SMARTS格式预测反应序列,并为其预测的反应生成所有反应物、产物与构建块的SMILES字符串。在推理阶段,给SynLlama的指令保持不变,输入部分的SMILES字符串由用户指定的字符串替换。正如补充图S1所示,SynLlama的响应遵循训练阶段所构造的提示-响应对所约束的输出结构。更具体地说,输出响应由两部分组成:reactions与building blocks。在reactions部分,模型以逆合成方式使用提供的反应模板逐步断键来拆解目标分子,每一步预测一个反应模板及该反应的反应物与产物,并持续进行直到无法继续反应。随后在building blocks部分,模型汇总所有构建块,即从reactions部分识别出那些在某些反应中作为反应物出现、但未在其他反应中作为产物出现的分子。推理过程的可视化示意以黑色标注展示于图1(d)。

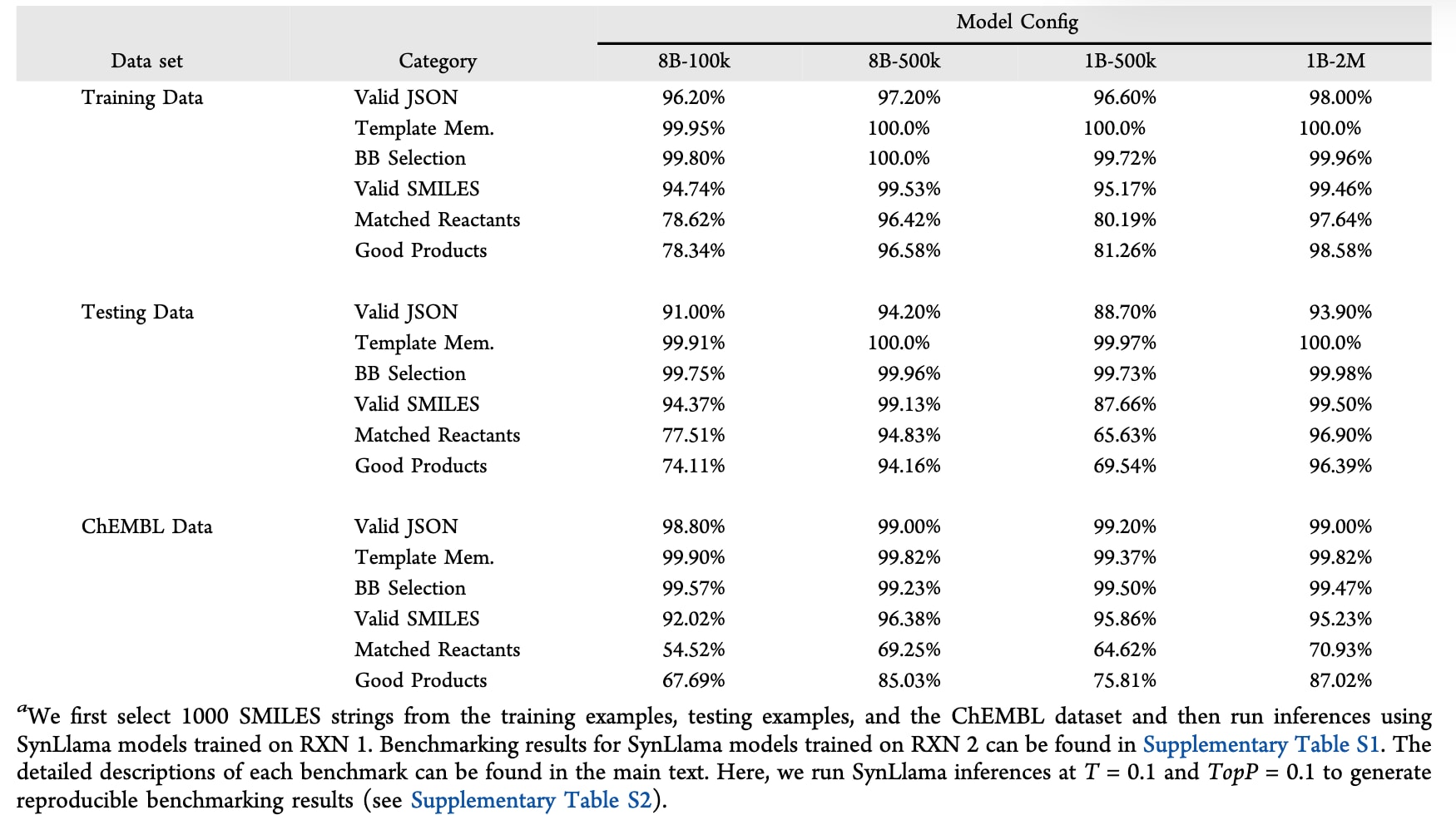

表1 | 展示了SynLlama在1000条训练数据、测试数据与ChEMBL数据上的推理基准评测。

2.3 SynLlama模型基准评测

由于该工作将合成任务完全表述为语言建模问题,其中反应用SMARTS模板表示、分子用SMILES字符串表示,因此需要量化SynLlama在指令遵循与反应化学理解方面的能力。为评估指令遵循能力,该方法选取了表1所示的三项指标。第一项为Valid JSON,用于检查模型输出是否为可解析的JSON格式,并且遵循微调阶段设定的模板,这一点对后续重构算法至关重要。第二项为Template Memorization,用于衡量模型对所提供反应模板的记忆能力,这些模板共同定义了可合成化学空间。第三项为BB Selection,用于评估模型在输出的building blocks部分中,能否从reactions部分准确识别并选出全部构建块。

为评估对反应化学的理解,该方法聚焦于单步反应,并总结为三项关键指标:(1)Valid SMILES占比,即输出中所有SMILES字符串里有效SMILES的比例,用于检验模型对基于字符串化学表示的总体学习效果;(2)Matched Reactants占比,用于计算生成的反应物是否与所预测反应中指定的反应物模板相匹配;(3)Good Products占比,用于评估将提出的反应模板应用到反应物上时,是否确实能够生成所预测的产物。整体而言,上述六项基准能够综合衡量SynLlama在字符串表示下的指令遵循能力与反应执行能力。

在表1中,四个已训练的SynLlama模型同时在分布内的训练数据以及分布外的测试数据与ChEMBL数据上进行评测,以对应上述指标。在指令遵循类指标上,多数模型在所有数据集上对微调后的响应结构均表现出很强的一致性,遵循比例超过90%。这一结果表明,当训练样本数量超过100000时,微调能够有效保留所要求的输出结构。此外,四个模型都能成功记忆给定的RXN模板,并且在超过99%的情况下,能够从所有预测反应物中正确选择构建块(BB)。这一能力进一步提升了下游重构算法与SynLlama原始输出之间的耦合效率,因为重构阶段只需要反应序列与预测构建块等信息即可开展工作。

在反应化学理解的评测结果中,出现了更清晰的趋势:无论参数规模大小,随着训练数据量增加,模型在三类数据集上的反应化学理解均有所提升。多数模型从训练数据迁移到测试数据时能较好保持性能,但在泛化到ChEMBL数据时,Matched Reactants与Good Products的下降更明显。其原因在于,测试数据与训练数据采用相同方式生成,只是更换了构建块集合;而ChEMBL数据则处于不同的化学空间,这一点此前已有研究指出。尽管在ChEMBL分子上的表现有所降低,补充图S2显示SynLlama-8B-500k与SynLlama-1B-2M在不依赖任何下游处理的情况下,仍能在超过50%的情形下生成完整且有效的合成路线。这说明仅凭SynLlama的原始输出,就可能对未见的药物样分子合成规划具有实际价值。

在对比SynLlama-8B-500k与SynLlama-1B-500k时,可以观察到当训练数据量相同时,更大参数规模的模型表现更好。尽管根据当前趋势,继续增加训练数据可能进一步提升8B模型的效果,但其更高的计算成本使这一方向不够实际。与此同时,SynLlama-8B-500k与SynLlama-1B-2M的微调计算开销大致相当,且两者的基准表现也较为接近,因此后续任务选择推进SynLlama-1B-2M,并将其简化称为SynLlama,主要原因是其推理速度更快。

2.4 从预测的逆合成结果进行重构

利用SynLlama输出中预测的RXN序列与BB序列,可以按推断顺序将预测的反应模板依次应用到构建块上,从而合成提出的目标分子或结构接近的类似物,这一过程如图1(d)的黑色标注所示。在部分情形下,预测的构建块能够与已知的Enamine构建块一致,从而保证生成分子仍位于一个既定且可用于合成的化学空间之内。然而,由于SynLlama具有生成式特性,有些预测构建块可能是新颖的,但仍能给出有效的合成路径。为保证可操作性,该方法仅报告那些能够通过Molport识别到其他供应商并可购买的新构建块。因此,尽管SynLlama主要依托Enamine构建块在预定义化学空间内生成分子,其输出也提供了一种替代性的分子构建策略,这一点将在结果部分再次讨论。

当输入分子无法被完整重构时,该方法通过将SynLlama预测的构建块映射到已知的Enamine构建块来生成类似物,从而在定义明确的Enamine化学空间中采样分子。在这种情形下,该方法采用基于不同分子表示的最近邻搜索,包括SMILES与Morgan指纹,从预测构建块出发采样其在Enamine库中的邻近构建块,如图1(d)中的彩色标注所示。由于SynLlama的输出中RXN序列与构建块是同步预测的,因此有效搜索空间会被约束为那些能够通过特定RXN模板发生反应的Enamine构建块。更小的Enamine搜索空间不仅有助于提升前向合成的成功率,也使得对输入分子片段的探索更为高效。最近邻搜索算法的更多细节在Supporting Information中给出。

在构建完整合成路径时,若某些反应可能产生多个产物,该方法会基于SMILES字符串相似度选择与预测产物最接近的那个产物。最终,如图1(e)所示,重构算法会迭代地使用全部预测的构建块与RXN序列来搭建合成路线,以重构原始分子或在可合成化学空间内生成其变体。该重构算法使SynLlama能够作为一个可合成分子生成器,并同时输出相应的合成路径。

3 结果

该部分评估SynLlama在对大量此前未见化合物进行合成规划时的表现,并进一步探讨SynLlama工作流程在真实药物发现场景中的实用性,包括与生成式算法的结合:在尽量保持分子化学性质的前提下提升候选分子的合成可及性,并在已定义的可合成空间内扩展活性化合物库,使其结合亲和力指标达到良好或进一步提升。

3.1 未见分子的合成规划

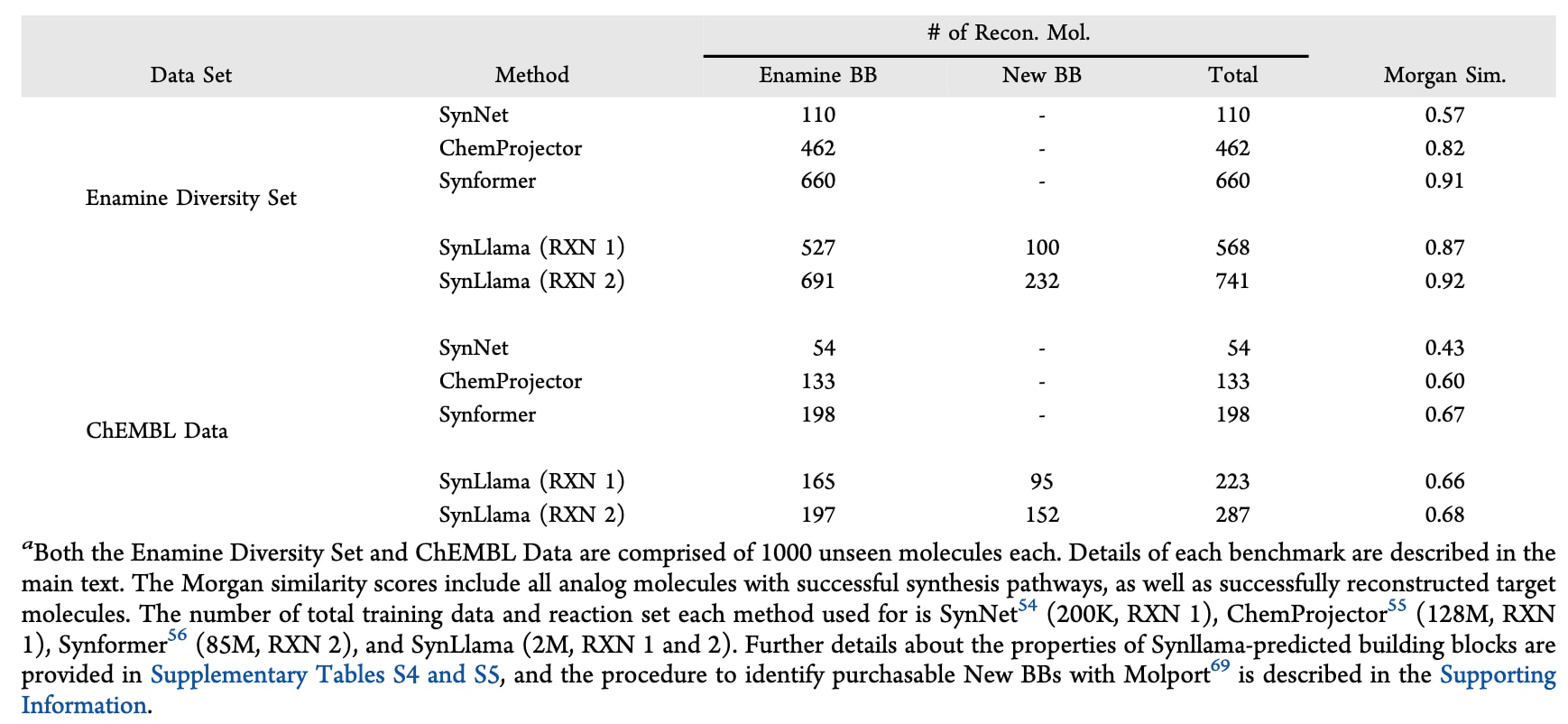

在表1中已经表明SynLlama模型能够稳定预测反应序列与构建块,因此接下来使用SynLlama为两组各1000个此前未见的分子进行合成规划,它们分别来自Enamine Diversity Set与公开的ChEMBL数据库。这两套数据集针对药物样分子,与SynLlama训练所用数据不同;两套分子的药物相关性质分布与训练数据的对比见图S3。在该验证中,重点检验已知可合成分子能否被baseline模型与SynLlama工作流程准确重构,相关汇总见表2。

首先采用SynNet、ChemProjector与Synformer等方法的标准重构设定,即仅使用Enamine库中的构建块来生成目标分子或类似物。在该对比中,SynNet与ChemProjector作为RXN1可合成化学空间覆盖能力的baseline,Synformer则作为扩展的RXN2模板下的baseline。如表2第一列与补充表S3所示,在各自对应反应集合训练且仅使用Enamine构建块的条件下,SynLlama在将训练数据量减少40到60倍的同时,仍优于上述三种方法。尽管在仅使用Enamine构建块时,SynLlama在ChEMBL重构成功率上高于SynNet与ChemProjector,并与Synformer大体相当,但相较于对Enamine Diversity Set的重构,所有方法在ChEMBL上的表现均出现下降。

为提升ChEMBL上的结果,该工作尝试对训练反应数据进行重新表述,加入额外过滤,使产物分子的分布更接近ChEMBL集合的药物样性质分布,如补充图S4所示。随后按照第2节相同流程进行有监督微调,期望更好地产生具有药物样性质分子的合成路径。然而,补充表S3显示,这种做法反而在Enamine Diversity Set与ChEMBL两类药物样目标上都带来性能损失。这一结果表明,相比用更严格的训练数据进一步“专门化”模型,让模型见到更丰富多样的产物分子分布,更有利于面向药物样目标的合成规划。此外,经整理的ChEMBL数据似乎具有独特性,在一定程度上处于由Enamine构建块与RXN模板构成的可合成空间之外。

不过,与只能使用Enamine构建块生成分子的baseline方法不同,SynLlama由于具备生成式能力,即便未针对这一点进行专门训练,仍额外具备使用超出Enamine范围的商业可得构建块来重构目标分子的能力。如表2所示,New BBs一列将新增构建块限制为可通过Molport购买的条目,它们为所有数据集与反应模板补充了更多可能的合成路径,从而提升目标分子的重构可能性。这一机制同样有助于ChEMBL数据,因为使用新构建块生成的分子仍保持药物样特征,见补充图S5。由于部分目标分子可能存在多条可行路径,既可仅用Enamine构建块合成,也可结合New BBs实现,因此表2中的Total列统计的是SynLlama能够重构出的不重复目标分子数量。在引入New BBs后,SynLlama的最佳重构率提升至:对Enamine Diversity Set中的1000个分子达到74.1%,对ChEMBL数据则提升到28.7%。这些结果说明SynLlama对反应化学的学习使其能够预测新颖构建块,从而提高合成可及性。

当目标分子无法被重构时,该工作通过分子相似度评估所生成类似物的质量,具体为基于4096位Morgan指纹计算目标分子与其最相似类似物之间的Tanimoto相似度。在表2中报告的相似度指标为所有生成分子的平均值,其中包含被完整重构的目标分子,这类分子的相似度记为1。补充表S6与S7还给出了基于Murcko骨架的4096位Morgan指纹相似度以及Gobbi二维药效团指纹相似度,并分别在包含或排除被完整重构目标分子的设置下进行统计。综合来看,这些结果共同表明SynLlama能够为相关类似物提供质量很高的合成规划,并且可购买构建块所带来的合成路径扩展起到了关键作用。

最后,补充表S3还比较了针对Enamine Diversity Set与ChEMBL数据的重构表现,包括采用正向合成而非逆合成的设置,以及来自树状合成路径的测试分子。结果显示,相较于正向合成,SynLlama在逆合成上的表现更好;而正向合成在Synformer中更容易取得成功。同时,在分支合成路径上,逆合成的表现也优于各类baseline方法。

表2 | 展示了不同方法之间的合成规划性能对比。

3.2 未见分子的合成规划

已有研究表明,生成模型为蛋白靶点提出的候选结合分子,往往在可靠性与实际可合成性两方面都存在挑战。尤其在药物发现中,由于对接评分本身的不可靠性会带来较高的假阳性率,药物化学家通常不愿投入时间与高昂资源去为命中分子进行复杂的定制合成。相比之下,若能找到与候选分子高度相关、且被限定在Enamine构建块范围内的近邻化合物,就可以通过低成本购买来先行验证命中,再进一步开展结构优化以获得先导分子。该部分展示SynLlama在连接生成式分子设计与可行合成之间的潜力,面向那些已针对药物应用场景(如结合实验)进行优化的分子,提供更具可操作性的合成替代方案。

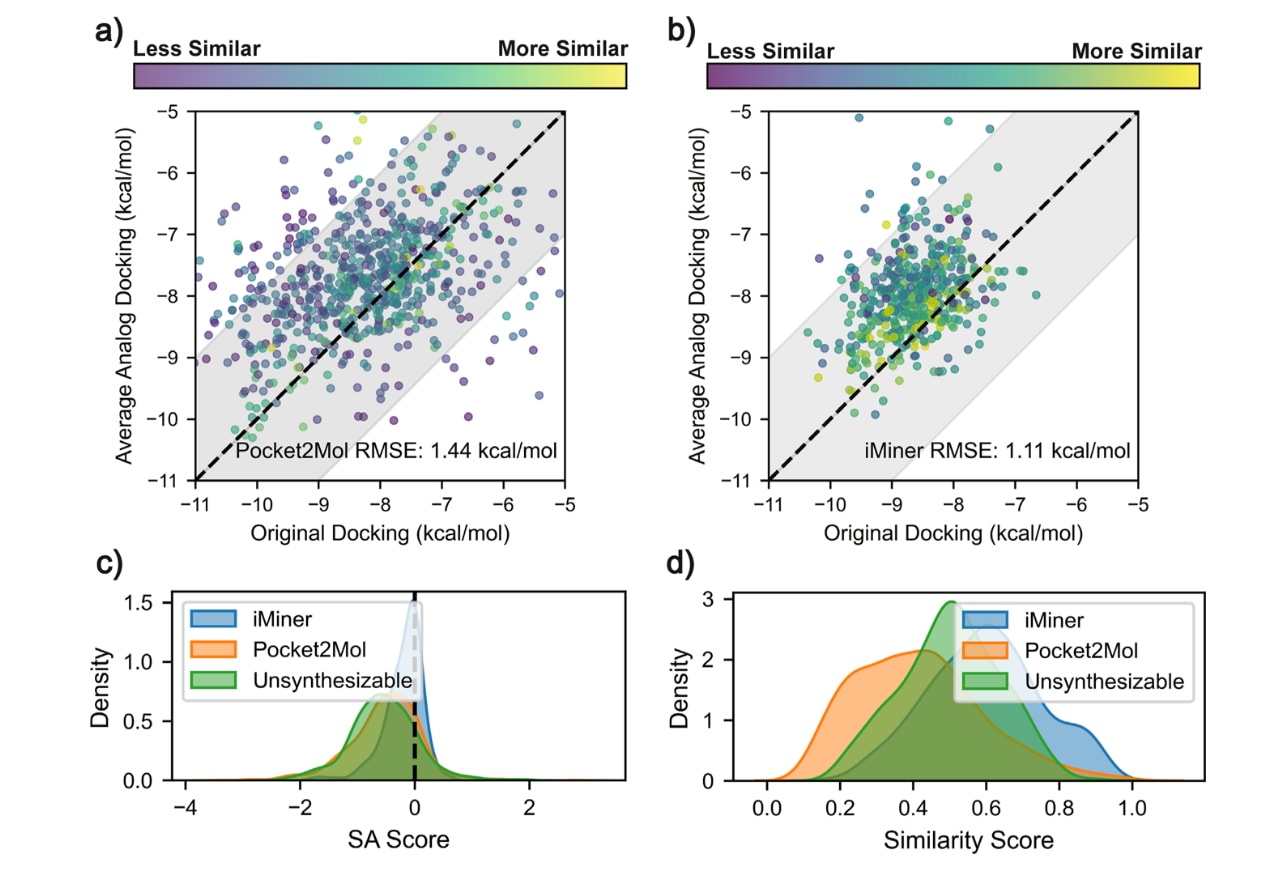

图2 | 展示了SynLlama在为Pocket2Mol与iMiner提出的SARS2 MPro、Thrombin与TYK2结合物生成可合成类似物方面的表现。 对比散点图,用于比较(a)Pocket2Mol与(b)iMiner生成分子的对接评分,以及基于RXN2训练的SynLlama为每个分子提出的10个最相似类似物的平均Vina对接评分。每个数据点按生成分子与其类似物之间的平均Morgan指纹相似度进行颜色编码。阴影区域表示对接能量不确定性范围为±2kcal/mol。(c)Pocket2Mol、iMiner生成的不可合成分子与SynLlama提出的类似物之间,合成可及性(SA)评分差值的分布。使用RXN1训练的SynLlama为iMiner生成的类似物得到的结果与补充图S6所示相近。补充图S7中的核密度结果进一步支持这一发现,即这些类似物在不削弱整体对接评分分布的前提下,会稳定地向更优的SA方向移动。(d)目标分子与其前10个候选类似物之间的平均Morgan指纹相似度分数。

具体而言,图2考察两种用于从头药物分子生成的方法:其一为从一维到三维的LSTM模型iMiner,会同时优化药物样性质与AutoDock-vina对接评分;其二为三维图Transformer模型Pocket2Mol,同样以AutoDock-vina对接评分为优化目标。使用iMiner为SARS-CoV-2主蛋白酶(SARS2 MPro)生成500个分子,并使用Pocket2Mol分别为Thrombin与TYK2各生成500个分子。一个值得注意的现象是,无论iMiner还是Pocket2Mol,其生成分子中仅有约1%能够通过SynLlama或ChemProjector完成合成重构,这表明这些生成模型往往会提出合成难度较高的目标分子。因此,针对每个蛋白靶点的全部500个候选分子,随后统一输入到基于RXN2训练的SynLlama流程中,生成被限制在Enamine构建块范围内的可合成类似物。对所有生成的类似物,采用与原始候选分子相同的流程,使用AutoDock-vina进行分子对接评估。

图2(a,b)显示,目标分子与其生成类似物之间的对接评分均方根误差(RMSE)分别为1.44kcal/mol(Pocket2Mol)与1.11kcal/mol(iMiner),二者均落在Trott等人报告的对接评分固有误差的可接受范围内。进一步地,如图2(c,d)所示,针对Pocket2Mol在Thrombin与TYK2上的候选分子,SynLlama生成的类似物在合成可及性(SA)方面呈现出显著改善,但相似度相较表2中的基准有所下降。对于iMiner在SARS2 MPro上的候选分子,SynLlama在略微提升SA的同时,仍能保持与表2基准相当的良好相似度。iMiner将药物样评分纳入损失函数这一设定可能解释其更优表现,另一种可能是SARS2 MPro相较Pocket2Mol所针对的Thrombin与TYK2更容易处理。

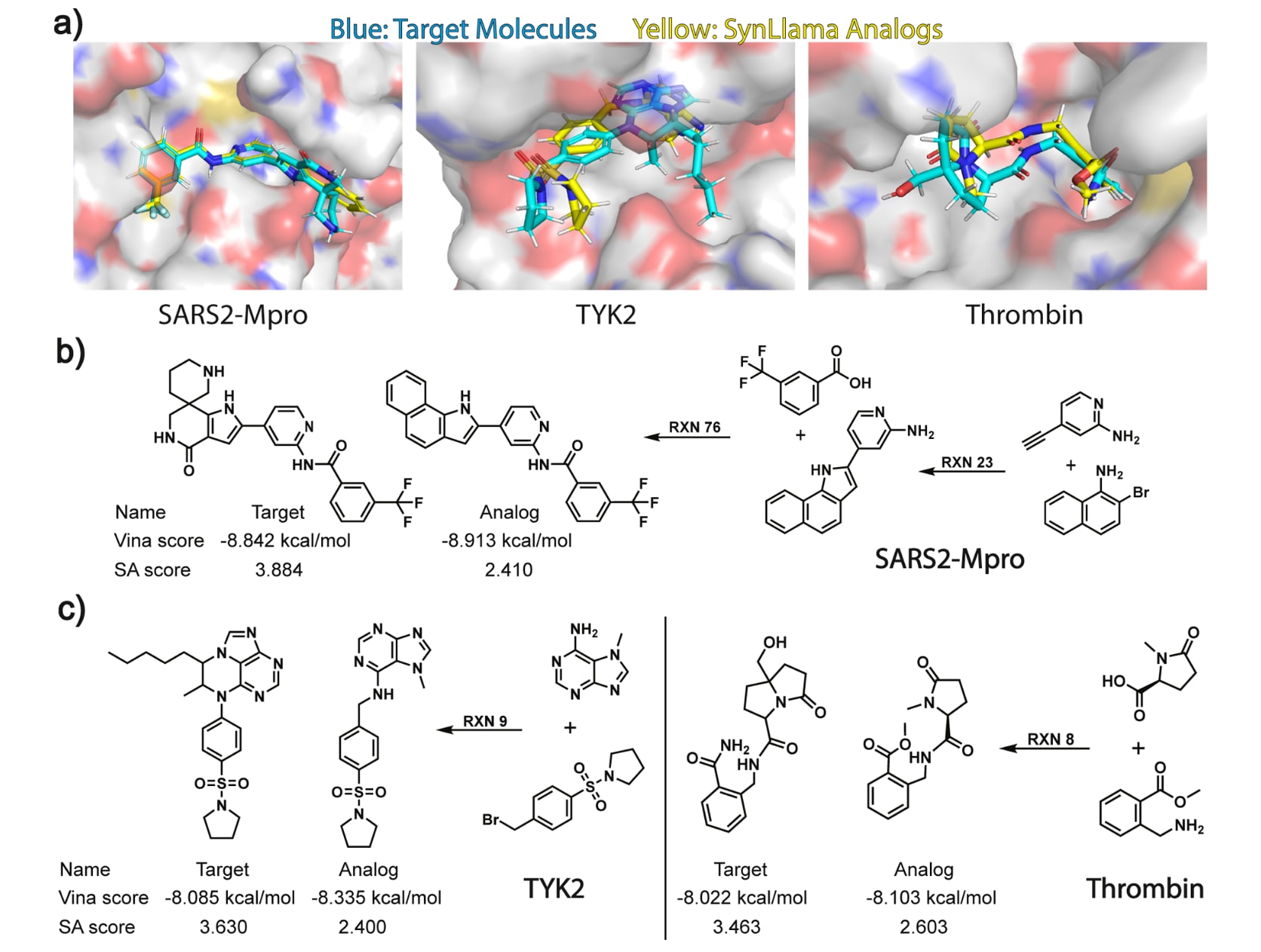

更易合成的类似物在结合方式上对原始生成分子具有良好保留,这一点可由图3(a)中三类蛋白对应的目标分子-类似物分子对的代表性对接构象直观验证。图3(b,c)进一步给出若干例子,展示由生成分子衍生的类似物所对应的合成路径。

最后还对一组由Gao等人通过ASKCOS判定为不可合成的分子进行比较。如图2所示,SynLlama为该集合生成的类似物相似度优于Pocket2Mol生成模型在前述任务中的相似度水平,并且这些类似物的SA分数出现显著下降,体现出SynLlama通过生成类似物来提升合成可及性的有效策略。补充图S8还给出若干具体的目标分子-类似物配对示例,其中在维持客观评分的同时,目标分子的合成可及性分数得到了显著降低。总体而言,这些结果共同表明,SynLlama能够为从头生成分子有效提出可合成的类似物,从而在不牺牲预期药物相关性质的前提下,显著提升其合成可及性。

图3 | 展示了使用iMiner为SARS2 MPro生成分子并由SynLlama给出可合成类似物的示例,以及使用Pocket2Mol为TYK2与Thrombin生成分子并由SynLlama给出可合成类似物的示例。 (a)三个蛋白靶点的对接构象可视化结果。(b)SARS2 MPro中,iMiner生成的目标分子与SynLlama提出的类似物的对接评分与SA评分,并同时给出预测的合成路径。(c)TYK2与Thrombin中,Pocket2Mol生成的目标分子与SynLlama提出的类似物的对接评分与SA评分,并同时给出各自预测的合成路径。

3.3 结合物命中分子的局部命中扩展

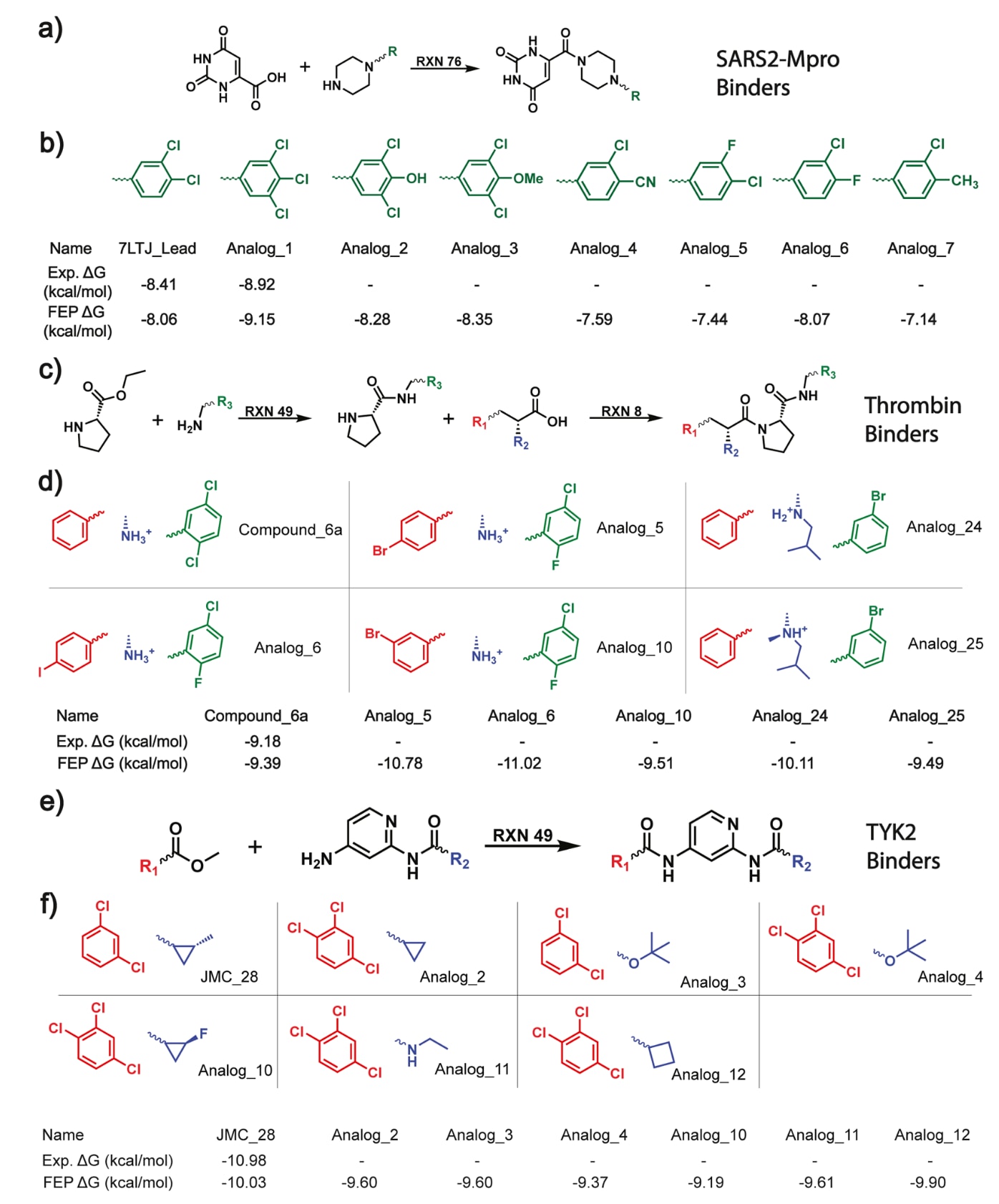

由于SynLlama会将用于合成的原始目标分子拆解为构建块,因此该方法天然支持围绕分子骨架的局部片段进行多样化探索,而不仅仅是对完整目标分子进行整体改造。在最后一项任务中,该方法被用于上一节涉及的三个蛋白靶点的命中分子扩展:SARS2 MPro、Thrombin与TYK2,目标是发现既可合成、又具有更优相对结合自由能(RBFE)的分子,并且该提升能够同时得到实验与高精度自由能微扰(FEP)计算的支持。

如图4(a)所示,SARS2 MPro的命中分子(7LTJ_Lead)以尿嘧啶与邻二氯苯为核心骨架,两者通过哌嗪连接体相连。参考Kneller等人的实验命中扩展研究,该工作沿用其策略,仅在苯环上提出官能团取代,同时保持连接体与尿嘧啶部分不变。对于Thrombin与TYK2,如图4(c,e)所示,该工作选择Schrodinger FEP基准测试集中的最佳表现分子作为命中分子。为在这些命中分子周围进行扩展,首先在基准测试集中为每组分子识别最大公共骨架,并以此骨架引导类似物的筛选与选择。具体做法是,使用SynLlama为每个命中化合物生成50个可合成类似物,并将构建块来源严格限制为Enamine构建块,随后筛选出能够保留该骨架的分子。最终,分别获得满足条件的类似物分子共8个、14个与11个,对应SARS2 MPro、Thrombin与TYK2。之后将这些类似物放置在与原始命中分子相近的构象位置,以用于后续FEP计算。

图4 | 展示了使用SynLlama对SARS2 MPro、Thrombin与TYK2结合物进行命中扩展。 (a,c,e)SynLlama预测的合成路径,用于在各蛋白靶点的命中分子基础上生成扩展类似物,取代位置以R基团标注。(b,d,f)命中化合物与SynLlama扩展得到的类似物的结合自由能。候选取代基的配色方案与预测合成路径保持一致。所有潜在结合物要么具有更优的FEP结合自由能,要么相较原始命中分子落在1kcal/mol的不确定性范围内。

为验证FEP结果的可靠性,首先在三个体系中各选择约10个已完成合成且经过实验测试的分子用于基准验证。补充图S9显示,计算得到的FEP数值与由IC50换算得到的实验

进一步而言,所有建议的类似物都同时给出了使用常见反应模板与Enamine可购买构建块的预测合成路径,这使其在药物发现中的实用性更为突出。由于具备同时兼顾小分子效力与合成可及性的综合能力,SynLlama在SARS2 MPro的命中扩展任务中成功重新发现了Kneller等人报告的最强效化合物Analog_1。此外,在Thrombin案例中,SynLlama探索了R2取代位点,该区域此前的分子系列并未覆盖,并且通过FEP展示出能够生成更高效力分子的能力。这些结果共同验证了SynLlama能够利用现成可得的构建块有效探索局部化学空间,为药物化学家加速命中扩展提供了一条直接且高效的路径。

4 总结

受到大型语言模型在化学领域最新进展的启发,该工作希望利用数据高效的有监督微调(SFT),将通用的Meta Llama3转化为SynLlama,使其成为一种基于大型语言模型的生成器,能够提出可合成分子,并为目标分子或其近似类似物推断合成路线。全文展示了一个核心结论:当SynLlama在从特定化学空间采样得到的合成路径数据上完成微调后,能够有效探索一个自定义的化学搜索空间,该空间由约230000个Enamine构建块(BB)与经过验证的有机反应模板(RXN)组成。更进一步地,尽管训练所用的合成路径数量比既有方法少近两个数量级,SynLlama在多项药物发现关键任务上仍展现出强劲表现。相关实验表明,SynLlama能够在药物发现的多个环节提供帮助,包括合成规划、为从头生成分子提供可合成类似物、以及围绕命中分子进行局部命中扩展。

由于SynLlama建立在通用大型语言模型之上,而不是从零开始训练,因此带来若干独特优势与可拓展空间。举例而言,在构造微调数据时,该工作从由230K个Enamine构建块与两套反应模板构成的预定义化学搜索空间进行采样,但并未把这些庞大的约束条件显式写入模型的上下文窗口。由此带来的结果是,在最大的数据规模仅为200万条合成路径时,模型对每个构建块的观测次数往往只有几十次,而每个反应模板的出现次数却可达到数十万次。因此,SynLlama能够高效记忆允许使用的RXN模板,但对Enamine构建块更多是学习其分布特征,这也使其能够外推到Enamine之外未见过但可购买的构建块。相较之下,ChemProjector与Synformer等方法只能在预定义的构建块搜索空间内探索,例如局限于Enamine Diversity Set之内,从而限制了它们利用新构建块提出替代合成路线的能力。

除具备对训练化学空间之外的外推能力外,SynLlama所采用的底座模型Llama-3.2-1B参数规模相对较小,因此若在更大的大型语言模型上配合更多数据与算力进行训练,理论上仍有望获得更强的预测能力。不过,实验也呈现出一个重要现象:即便参数更少的小模型,在相对少量数据的SFT之后,也能够被转化为胜任复杂任务的专家模型。这为在各类化学任务中使用更小的专家模型创造了机会,更快的推理速度也可能使其在实际应用中更具吸引力。

此外,温度与top-p等最优超参数,会在训练与推理阶段、以及不同下游任务之间产生差异。在推理时,多数有效的原始输出往往在较低温度与较低top-p设置下生成。然而,当模型与重构算法结合使用,且下游过程对反应化学的严格一致性要求降低时,可以采用更高的温度与top-p,从而更广泛地探索Enamine化学空间,生成更加多样且更相关的类似物。这一特性在需要大量探索的任务中尤为重要,例如文中展示的命中扩展案例。

另一个值得关注的方向是将SynLlama与其他生成模型耦合。相关结果显示,该组合能够在保持良好对接评分的同时,将候选分子稳定地推向更优的合成可及性评分。这提示SynLlama可以作为其他从头生成模型的后处理器,在保留目标性质的同时,输出更可合成且具有清晰反应路径的化合物。放眼药物发现领域,大型语言模型带来的诸多机会中,其自然语言交互能力与近期推理能力的提升尤具吸引力,因为这使得缺少编程经验的使用者也能直接与模型交互,从而在计算方法与实验研究之间建立更直接的连接。

该工作还提出一种设想:专家用户可以通过提示工程与数据微调,将比该研究更贴近真实研发流程的因素纳入模型能力范围。例如,药物化学家可以在这一具有泛化性的SFT框架下,使用自行选择的构建块与反应模板对模型进行微调;同时还可在更细粒度的合成规划中考虑合成成本、反应条件、选择性提升以及特定反应步骤的保护与去保护因素等。整体而言,该工作可被视为一次初步尝试,用于展示大型语言模型在真实实验研究中的有效性,并推动后续研究更充分地利用这类模型。